Professional Documents

Culture Documents

Conceptos de Estadistica

Uploaded by

Emily GomezCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Conceptos de Estadistica

Uploaded by

Emily GomezCopyright:

Available Formats

Inferencia: El conjunto de mtodos estadsticos que permiten deducir (inferir) como se distribuye la poblacin en estudio o las relaciones estocsticas

entre varias variables de inters a partir de la informacin que proporciona una muestra. Estimacin de parmetros poblacionales o simplemente parmetros: utiliza principios de muestreo, como la media y la varianza poblacional, a partir de los estadsticos muestrales correspondientes, como la media y la varianza muestral. Pruebas estadsticas de estimacin y contraste: frecuentemente empleadas se basan en suponer que se ha obtenido una muestra aleatoria de una distribucin de probabilidad de tipo normal o de Gauss. Estimacin de media a nivel de muestras grandes y pequeas: Un estimador es una regla que expresa cmo calcular la estimacin, basndose en la informacin de la muestra y se enuncia, en general, mediante una frmula. Poblacin: es un conjunto homogneo de individuos sobre los que se estudia una o varias caractersticas que son, de alguna forma, observables. Muestra: es un subconjunto de la poblacin. El nmero de elementos de la muestra se denomina tamao muestral. Muestreo aleatorio simple: es aquel en el que todos los individuos de la poblacin tienen la misma probabilidad de ser elegidos. Muestra aleatoria sistemtico, de una variable aleatoria X, con distribucin F, de tamao n, es un conjunto de n variables aleatorias X1,X2,...,Xn, independientes e igualmente distribudas (i.i.d.) con distribucin F. Espacio muestral: es el conjunto de muestras posibles que pueden obtenerse al seleccionar una muestra aleatoria, de tamao n, de una cierta poblacin. Parmetro: es cualquier caracterstica medible de la funcin de distribucin de la variable en estudio (media, varianza,..). Estadstico: es una funcin de la muestra T. Por tanto, es una variable aleatoria que tiene una funcin de distribucin que se denomina distribucin en el muestreo de T. Los estadsticos independientes del parmetro a estimar se denominan estimadores.

Se pueden usar distintos estimadores para estimar un mismo parmetro. Por ejemplo para estimar la media poblacional se puede usar la media muestral, la mediana, la moda, el promedio entre el valor ms chico y ms grande de la muestra, etc.. Cada estimador obtenido de muestras de tamao fijo n, vara con cada muestra que se toma. Por lo tanto, los estimadores son variables aleatorias y pueden considerarse sus distribuciones muestrales (similar a los estadsticos que se estudiaron la clase pasada). La distribuciones de muestreo de los estimadores se usan para compararlos y decidir cual de todos es el mejor. Se prefiere un estimador que tenga una distribucin muestral cuya media coincida con el parmetro que se desea estimar y cuya extensin o dispersin (medida con la variancia) sea lo menor posible. Notacin. Si denota un parmetro entonces denotar la estadstica correspondiente. Como dijimos anteriormente, se prefiere una estadstica que tenga una distribucin muestral cuya media coincida con el parmetro que se desea estimar. Un estimador de este tipo se llama insesgado. Si es un estimador de un parmetro y si la media de la distribucin de es , es decir, E( ) = ,

entonces se dice que es un estimador insesgado. De otra manera, se llama sesgado.

las distribuciones muestrales de dos estimadores , el primero insesgado, E( ) = , y el segundo sesgado, E( ) > . Si se calcula una vez lo ms probable es que se encuentre cerca de la media E( ). Entonces en el primer caso lo ms probable es que se encuentre cerca de y en el segundo que sea ms grande que . Se prefiere una estadstica que adems tenga una distribucin muestral cuya extensin o dispersin (medida con la variancia) sea lo menor posible. Nota: Para simplificar se habla de variancia del estimador para referirnos a la variancia de la distribucin muestral del estimador. En la figura 6.3, p. 199, aparecen las distribuciones muestrales de dos estimadores insesgados , E( ) = . Si se calcula una vez , en ambos casos, lo ms probable es que se encuentre cerca de la media E( ). Pero como la desviacin estndar del primero es menor que la del segundo, es ms probable que en el primer caso se encuentre ms cerca de la media que en el segundo caso. En base a lo anterior se elige de todas las estadsticas disponibles aquella con el menor sesgo y variancia posible. Ms an, el mejor estimador posible es aquel que es insesgado y que de todos los insesgados tiene la menor variancia, a este estimador se lo llama estimador insesgado de menor variancia (EIMV). Ejemplos de estimadores insesgados. Media muestral x (estimador insesgado de la media poblacional ) Si se seleccionan muestras aleatorias de n mediciones de una poblacin con media y desviacin estndar , la distribucin de muestreo de x tendr media E( x ) = . y desviacin estndar x =/ n .

Proporcin muestral p (estimador insesgado del parmetro p). Si se seleccionan muestras aleatorias de n observaciones de una poblacin binomial, con parmetro p, la distribucin de muestreo de la proporcin muestral p = E( p ) = p y desviacin estndar

p =

x tendr media n

pq n

Diferencia de medias x 1 x 2 (estimador insesgado del parmetro 1 2). Se tienen dos poblaciones I y II con medias y desviaciones estndar (1, 1) y (2, 2), respectivamente. Se seleccionan en forma independiente muestras de tamao n1 para I y de tamao n2 para II. Si x 1 y x 2 son las medias muestrales para tales muestras, entonces la distribucin de muestreo de x 1 x 2 tendr media E( x 1 x 2) = 1 2 y desviacin estndar

x1 x 2 =

2 12 2 + n1 n2

Proporcin muestral p 1 p 2 (estimador insesgado del parmetro p1 p2)

Se tienen dos poblaciones binomiales I y II con parmetros p1 y p2, respectivamente. Se seleccionan en forma independiente muestras de tamao n1 para I y de tamao n2 para II. Si p 1 y p 2 son las proporciones muestrales de tales muestras, entonces la distribucin de muestreo de p 1 p 2 tendr media

E( p 1 p 2) = p1 p2 y desviacin estndar

p1 p2 =

p1 q1 p 2 q 2 + n1 n2

Observar que en cada caso, se toma como estimador la estadstica que corresponde al parmetro que se quiere estimar. La media muestral, la proporcin muestral, la diferencia de medias muestrales y la diferencia de proporciones muestrales tienen una distribucin de muestreo que se aproxima a una normal cuando el tamao de la/s muestra/s es grande. Como regla prctica se supone que esto se cumple cuando n 30. Teniendo en cuenta esto y como estamos interesados en muestras grandes, en adelante supondremos que n 30, y que trabajamos con un estimador insesgado de que tiene una distribucin normal. Una manera de evaluar la bondad de una estimacin puntual es a travs de la distancia entre el estimador y el parmetro. Esta cantidad se denomina Error de estimacin. | |. Como se desea que este error sea lo menor posible, interesa saber si es menor que una cierta cota que se suele expresar en trminos de la desviacin estndar del estimador: Cota para el error de estimacin. c . Ahora bien, no se puede saber si | | < c pues desconocemos . Sin embargo, conociendo las caractersticas de la distribucin de , se puede calcular la probabilidad de que | | < c , es decir, P(| | < c )

Por ejemplo, si c = 1.96 y suponiendo que la distribucin de es normal, P(| | < 1.96 ) = 0.95 En la siguiente figura aparece el rea correspondiente.

Ejemplo. Se quiere estimar la media de una poblacin. Se toma una muestra de tamao n = 50 y se obtiene x = 9.1, s = 0.24. Dar una estimacin para y evaluar la exactitud de la estimacin con c = 1.96. Parmetro

Estimador x (insesgado E( x ) = y tiene una distribucin de muestreo normal si el tamao de la muestra es grande). Estimacin para : 9.1. Cota para el error de estimacin (usando s para aproximar ): 1.96 x = 1.96 / n 1.96 s / n = 1.96 0.24 / 50 0.07. Como P(| x | < 1.96 x ) = 0.95 P(| x | < 0.07) = 0.95 podemos decir que la probabilidad de que el error de estimacin sea menor que 0.07 es de 95%. En la siguiente figura aparece el rea correspondiente.

INTERVALOS DE CONFIANZA PARA MUESTRAS GRANDES Un estimador por intervalo utiliza los datos de la muestra para obtener dos valores numricos entre los cuales se dice que est el valor del parmetro estimado. Supongamos que queremos estimar la media de una poblacin. Se toma una muestra de tamao n y se determina con los datos de la muestra un intervalo [a 1, b1]. Se espera que [a1, b1] contenga a , pero puede suceder que esto no ocurra. Se toma otra muestra de tamao n y se determina con los datos de la muestra un intervalo [a 2, b2]. Se tambin en este caso que [a2, b2] contenga a , pero igual que antes puede suceder que esto no ocurra. Se puede repetir este procedimiento varias veces, digamos m, obtenindose un conjunto de intervalos [a1, b1], [a2, b2], ..., [am, bm]. Se espera que el estimador por intervalo, es decir, el procedimiento que se est usando para determinar cada intervalo, sea tal que un gran porcentaje de estos intervalos contenga a . El razonamiento anterior se puede hacer con cualquier otro parmetro . Cada uno de estos intervalos se llama intervalo de confianza y la probabilidad de que el intervalo contenga a se llama coeficiente de confianza. Ahora veremos como se determinan los intervalos de confianza y el coeficiente de confianza. Sea un estimador insesgado de que tiene una distribucin muestral normal o aproximadamente normal. Se tiene

Error de estimacin. | |

Cota para el error de estimacin. 1.96 (se expresa en trminos de la desviacin estndar).

P(| | < 1.96 ) = 0.95 (para obtener este valor de P se tiene en cuenta que la distribucin de es normal y se usa la tabla 4)

Como P(| | < 1.96 ) = 0.95 puede escribirse como P( [ 1.96 , + 1.96 ]) = 0.95, podemos decir que la probabilidad de que [ 1.96 , + 1.96 ] contenga a es 0.95 = 95%.

De este modo, si es una estimacin particular de , entonces [ 1.96 , + 1.96 ]

es un intervalo de confianza para con un coeficiente de confianza de 95%, ms brevemente intervalo de confianza de 95%. Adems lmite inferior de confianza: LIC = 1.96 lmite superior de confianza: LSC = + 1.96

Ms general, para establecer el intervalo de confianza con nivel de confianza (1 )%, sea z la normal

estandarizada correspondiente a : z = . P(| | < c ) = 1 P(| z | < c ) = 1

P( < z < c) = 1 2 P(0 < z < c) = 1 P(0 < z < c) = (1 ) / 2 c 1/2 P( c < z ) = (1 ) / 2 P( c < z ) = /2. Por esta razn, si se escribe c = z/2 se tiene Intervalo de confianza de (1 )% para , usando un estimador insesgado que tiene una distribucin muestral normal. [ /2 , + z/2 ] es un intervalo de confianza de 1 z , lmite inferior de confianza: lmite superior de confianza: LIC = z/2

LSC = + z/2

donde z/2 es tal que P(z/2 < z ) = /2, o equivalentemente, P(0 < z < z/2) = (1 ) / 2 (ver figura 6.8, p. 204) Estos casos particulares se obtienen reemplazando en cada caso por el estimador que corresponda a y con la desviacin estndar de . (En Ejemplos de estimadores insesgados en p. 2 de este apunte aparecen en

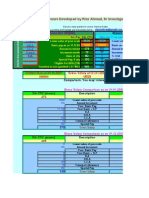

cada caso las expresiones de y , y que condiciones se deben cumplir. En particular, el tamao de la/s muestra/s es n 30 para que el estimador tenga una distribucin aproximadamente normal). Usando la tabla 4 se puede calcular Coeficiente de confianza LIC LSC (1 ) / 2 z/2 1 c + c 0.90 0.45 1.645 1.645 + 1.645 0.95 0.99 0.475 0.495 1.96 2.575

1.96 2.575

+ 1.96 + 2.575

Veamos como se obtienen los valores de z/2 para distintos valores de . Por ejemplo, se quiere determinar el valor de z/2 para obtener un intervalo de confianza que tenga coeficiente de confianza 1 = 90%= 0.9. Como (1 ) / 2 = 0.45, se debe ubicar en la tabla 4 de la normal, un valor de z/2 tal que

P(0 < z < z/2) = (1 ) / 2 = 0 .45. En la tabla 4, no hay ningn valor de probabilidad igual a 0.45, sin embargo los valores ms cercanos a 0.45 son 0.4495 que corresponde a P(0 < z < 1.64) ( P(0 < z < 1.64) = 0.4495 ) 0.4505 que corresponde a P(0 < z < 1.65) ( P(0 < z < 1.65) = 0.4505 ) cumplindose 0.45 = (0.4495 + 0.4505) / 2. Luego se toma z/2 = (1.64 + 1.65) / 2 = 1.645. Nota: Se elige el valor de z/2 que d la probabilidad que est ms cerca de (1 ) / 2 , o bien, si (1 ) / 2 est a la mitad de dos valores de probabilidad se procede como en el caso anterior. Ejemplo. Se quiere estimar la media de una poblacin. Se toma una muestra de tamao n = 50 y se obtiene s = 0.24. x = 9.1 Encontrar un intervalo de confianza de 90% para . Parmetro Estimador x (insesgado E( x ) = y tiene una distribucin de muestreo normal si el tamao de la muestra es grande). Debemos encontrar z/2 tal que P(| x | < z/2 x ) = 0.90 Segn la tabla anterior, z/2 = 1.645. As P(| x | < 1.645 x ) = 0.90. Como x = 9.1

x = / n s / n = 0.24 / 50 0.034 1.645 x 1.645 0.034 0.056

entonces P(|9.1 | < 0.056) = 0.90 Conclusin: El intervalo [9.1 0.056, 9.1 + 0.056] = [9.044, 9.156] contiene a con una probabilidad de 90%. Los intervalos de confianza que hemos considerado hasta ahora se suelen llamar intervalos de confianza bilaterales. Se pueden determinar tambin los Intervalos de confianza unilaterales de (1 )% para , usando un estimador insesgado que tiene una distribucin muestral normal o aproximadamente normal. [ z , ) es un intervalo de confianza unilateral inferior de 1 , lmite inferior de confianza: LIC = z

(, + z ] es un intervalo de confianza unilateral superior de 1 , lmite superior de confianza: LSC = + z

donde z es tal que P(z < z ) = , o equivalentemente, P(z < z) = 1 (ver figura 6.9. p. 206)

TAMAO DE LA MUESTRA Tal como dijimos la clase anterior, se supone que se trabaja con muestras aleatorias. Ahora veremos como se determina el tamao de la muestra de modo tal que el error de estimacin sea menor que una cierta constante B con una probabilidad de 1 , es decir, P(| | < B) = 1

Como la cota para el error de estimacin se expresa como z/2 , se busca un tamao de muestra n tal que z/2 = B. Para la mayora de los estimadores depende de n. En particular, esto se cumple para todos los estimadores que vemos en este curso (recordar expresiones para para cada estadstica). Ejemplo. Determinar el tamao de la muestra para que el error al estimar la media de una poblacin sea menor que 0.06 con una probabilidad de 0.95, sabiendo que se tom una muestra de tamao n = 50 y se obtuvo x = 9.1 y s = 0.24. Se busca un tamao de muestra n tal que P(| x | < 0.06) = 0.95 O equivalentemente, se busca un tamao de muestra n tal que z/2 = 0.06 con 1 = 0.95. Como (1 )/2 = 0.475, segn la tabla 4, P(0 < z < z/2) = (1 )/2 para z/2 = 1.96 Se busca entonces un tamao de muestra n tal que z/2 x = 1.96 x = 1.96 / n = 0.06 de donde n=

se desconoce pero se puede aproximar con el valor s que corresponde a la muestra de n = 50.

1.96 2 . 0.06

2

1.96 n= 0.24 2 = 61.5 0.06

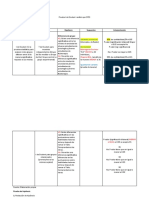

es decir, n = 62. Nota. Si no hubiramos tenido la estimacin s dada por una muestra anterior, podramos haber recurrido a la regla emprica para dar un valor aproximado de , siempre y cuando conociramos en que intervalo caen las mediciones, esto es, cual es el menor y mayor valor posible para las mediciones. Esta regla nos dice que el intervalo ( 2) contendr aproximadamente 95% de las mediciones. Este intervalo tiene longitud 4. Adems supongamos que sabemos que las mediciones caen en un intervalo de longitud 1. Luego 4 1 1 / 4 = 0.25. CONCEPTOS BSICOS PARA EL PROCEDIMIENTO DE PRUEBAS DE HIPTESIS. Hiptesis Estadstica: Al intentar alcanzar una decisin, es til hacer hiptesis (o conjeturas) sobre la poblacin aplicada. Tales hiptesis, que pueden ser o no ciertas, se llaman hiptesis estadsticas. Son, en general, enunciados acerca de las distribuciones de probabilidad de las poblaciones. Hiptesis Nula. En muchos casos formulamos una hiptesis estadstica con el nico propsito de rechazarla o invalidarla. As, si queremos decidir si una moneda est trucada, formulamos la hiptesis de que la moneda es buena (o sea p = 0,5, donde p es la probabilidad de cara). Analgicamente, si deseamos decidir si un procedimiento es mejor que otro, formulamos la hiptesis de que no hay diferencia entre ellos (o sea. Que cualquier diferencia observada se debe simplemente a fluctuaciones en el muestreo de la misma poblacin). Tales hiptesis se suelen llamar hiptesis nula y se denotan por Ho. Para todo tipo de investigacin en la que tenemos dos o ms grupos, se establecer una hiptesis nula. La hiptesis nula es aquella que nos dice que no existen diferencias significativas entre los grupos.

Por ejemplo, supongamos que un investigador cree que si un grupo de jvenes se somete a un entrenamiento intensivo de natacin, stos sern mejores nadadores que aquellos que no recibieron entrenamiento. Para demostrar su hiptesis toma al azar una muestra de jvenes, y tambin al azar los distribuye en dos grupos: uno que llamaremos experimental, el cual recibir entrenamiento, y otro que no recibir entrenamiento alguno, al que llamaremos control. La hiptesis nula sealar que no hay diferencia en el desempeo de la natacin entre el grupo de jvenes que recibi el entrenamiento y el que no lo recibi. Una hiptesis nula es importante por varias razones: Es una hiptesis que se acepta o se rechaza segn el resultado de la investigacin. El hecho de contar con una hiptesis nula ayuda a determinar si existe una diferencia entre los grupos, si esta diferencia es significativa, y si no se debi al azar. No toda investigacin precisa de formular hiptesis nula. Recordemos que la hiptesis nula es aquella por la cual indicamos que la informacin a obtener es contraria a la hiptesis de trabajo. Al formular esta hiptesis, se pretende negar la variable independiente. Es decir, se enuncia que la causa determinada como origen del problema flucta, por tanto, debe rechazarse como tal. Otro ejemplo. Hiptesis: el aprendizaje de los nios se relaciona directamente con su edad. Hiptesis Alternativa. Toda hiptesis que difiere de una dada se llamar una hiptesis alternativa. Por ejemplo: Si una hiptesis es p = 0,5, hiptesis alternativa podran ser p = 0,7, p " 0,5 p > 0,5. Una hiptesis alternativa a la hiptesis nula se denotar por H1. Al responder a un problema, es muy conveniente proponer otras hiptesis en que aparezcan variables independientes distintas de las primeras que formulamos. Por tanto, para no perder tiempo en bsquedas intiles, es necesario hallar diferentes hiptesis alternativas como respuesta a un mismo problema y elegir entre ellas cules y en qu orden vamos a tratar su comprobacin. Las hiptesis, naturalmente, sern diferentes segn el tipo de investigacin que se est realizando. En los estudios exploratorios, a veces, el objetivo de la investigacin podr ser simplemente el de obtener los mnimos conocimientos que permitan formular una hiptesis. Tambin es aceptable que, en este caso, resulten poco precisas, como cuando afirmamos que "existe algn tipo de problema social en tal grupo", o que los planetas poseen algn tipo de atmsfera, sin especificar de qu elementos est compuesto. Los trabajos de ndole descriptiva generalmente presentan hiptesis del tipo "todos los X poseen, en alguna medida, las caracterstica Y". Por ejemplo, podemos decir que todas las naciones poseen algn comercio internacional, y dedicarnos a describir, cuantificando, las relaciones comerciales entre ellas. Tambin podemos hacer afirmaciones del tipo "X pertenece al tipo Y", como cuando decimos que una tecnologa es capital intensiva. En estos casos, describimos, clasificndolo, el objeto de nuestro inters, incluyndolo en un tipo ideal complejo de orden superior. Por ltimo, podemos construir hiptesis del tipo "X produce (o afecta) a Y", donde estaremos en presencia de una relacin entre variables. Errores de tipo I y de tipo II. Si rechazamos una hiptesis cuando debiera ser aceptada, diremos que se ha cometido un error de tipo I. Por otra parte, si aceptamos una hiptesis que debiera ser rechazada, diremos que se cometi un error de tipo II. En ambos casos, se ha producido un juicio errneo. Para que las reglas de decisin (o no contraste de hiptesis) sean buenos, deben disearse de modo que minimicen los errores de la decisin; y no es una cuestin sencilla, porque para cualquier tamao de la muestra, un intento de disminuir un tipo de error suele ir acompaado de un crecimiento del otro tipo. En la prctica, un tipo de error puede ser ms grave que el otro, y debe alcanzarse un compromiso que disminuya el error ms grave. La nica forma de disminuir ambos a la vez es aumentar el tamao de la muestra que no siempre es posible. Niveles de Significacin. Al contrastar una cierta hiptesis, la mxima probabilidad con la que estamos dispuesto a correr el riesgo de cometern error de tipo I, se llama nivel de significacin. Esta probabilidad, denota a menudo por se, suele especificar antes de tomar la muestra, de manera que los resultados obtenidos no influyan en nuestra eleccin.

En la prctica, es frecuente un nivel de significacin de 0,05 0,01, si bien se une otros valores. Si por ejemplo se escoge el nivel de significacin 0,05 ( 5%) al disear una regla de decisin, entonces hay unas cinco (05) oportunidades entre 100 de rechazar la hiptesis cuando debiera haberse aceptado; Es decir, tenemos un 95% de confianza de que hemos adoptado la decisin correcta. En tal caso decimos que la hiptesis ha sido rechazada al nivel de significacin 0,05, lo cual quiere decir que tal hiptesis tiene una probabilidad 0,05 de ser falsa.

You might also like

- A Jugar en Familia PDFDocument6 pagesA Jugar en Familia PDFEmily GomezNo ratings yet

- Adivina Quién Eres PDFDocument1 pageAdivina Quién Eres PDFEmily GomezNo ratings yet

- Universidad Pedagógica Experimental Libertador: Caracas, 02 de Mayo de 2001 Depósito Legal PP 88-0343 Año XIV Número 1Document11 pagesUniversidad Pedagógica Experimental Libertador: Caracas, 02 de Mayo de 2001 Depósito Legal PP 88-0343 Año XIV Número 1Emily GomezNo ratings yet

- Evaluación en Nivel Superior PDFDocument41 pagesEvaluación en Nivel Superior PDFAfabiNo ratings yet

- Atención Integral Temprana A Niños y Niñas ConDocument14 pagesAtención Integral Temprana A Niños y Niñas ConEmily GomezNo ratings yet

- Etapas de LectoescrituraDocument4 pagesEtapas de LectoescrituraMila Flores RuizNo ratings yet

- Fco Javier Perez Deterioro Del LengDocument4 pagesFco Javier Perez Deterioro Del LengEmily GomezNo ratings yet

- ContructosDocument2 pagesContructosEmily GomezNo ratings yet

- Instrument Os Medici OnDocument18 pagesInstrument Os Medici OnEmily GomezNo ratings yet

- 6th Central Pay Commission Salary CalculatorDocument15 pages6th Central Pay Commission Salary Calculatorrakhonde100% (436)

- La Ensenanza de La Investigacion Cualitativa SANDINDocument16 pagesLa Ensenanza de La Investigacion Cualitativa SANDINEmily GomezNo ratings yet

- Guia Variable PDFDocument5 pagesGuia Variable PDFEmily GomezNo ratings yet

- Reform ADocument39 pagesReform AminunboxNo ratings yet

- Marco Del Buen Desempeño Docente - RM 0547-12-EdDocument56 pagesMarco Del Buen Desempeño Docente - RM 0547-12-EdAnonymous jST8CZPNo ratings yet

- Problematic A 1Document6 pagesProblematic A 1Emily GomezNo ratings yet

- Problematic A 1Document6 pagesProblematic A 1Emily GomezNo ratings yet

- Estimacion EstadisticaDocument8 pagesEstimacion Estadisticagiovanny_medina_8No ratings yet

- Presentación Visual PERTINENCIA SOCIALDocument7 pagesPresentación Visual PERTINENCIA SOCIALEmily GomezNo ratings yet

- Teorías científicas según KuhnDocument23 pagesTeorías científicas según KuhnEmily GomezNo ratings yet

- Cambios Paradigmaticos en La Educacion Especial en VenezuelaDocument12 pagesCambios Paradigmaticos en La Educacion Especial en VenezuelaEmily GomezNo ratings yet

- 06.deficiencias SensorialesDocument23 pages06.deficiencias SensorialesdenasrNo ratings yet

- Aplicación de estadística descriptiva y probabilidad para resolver problemasDocument12 pagesAplicación de estadística descriptiva y probabilidad para resolver problemaspitmur0% (1)

- Newbold EstadisticaDocument15 pagesNewbold EstadisticaVemyony CN9% (11)

- Clases Virtuales Estadistica Probalidades 2021Document24 pagesClases Virtuales Estadistica Probalidades 2021Maria FernandaNo ratings yet

- Tema 4Document28 pagesTema 4nicolásNo ratings yet

- Libro Estadistica Matos 2020Document10 pagesLibro Estadistica Matos 2020fortunatocontrerasNo ratings yet

- Estadística II: Práctica N.1. Módulo 1 de distribuciones de probabilidad y variables aleatoriasDocument4 pagesEstadística II: Práctica N.1. Módulo 1 de distribuciones de probabilidad y variables aleatoriasKreitzEvelynNo ratings yet

- Tarea 2 CONSTRUCCIÓN DE UN DOCUMENTO DE APLICACIÓN DE CONCEPTOSDocument8 pagesTarea 2 CONSTRUCCIÓN DE UN DOCUMENTO DE APLICACIÓN DE CONCEPTOSLeidy NoriegaNo ratings yet

- Geoestadistica Reservas ProbablesDocument17 pagesGeoestadistica Reservas ProbablesmisaelNo ratings yet

- Ejercicios de Repaso para El Examen Parcial (Solucionario)Document5 pagesEjercicios de Repaso para El Examen Parcial (Solucionario)Estefani YCNo ratings yet

- Prueba T de Student Análisis Por SPSSDocument14 pagesPrueba T de Student Análisis Por SPSSVermellets Cok-KirmiziNo ratings yet

- 06 Desviaci N Media Varianza Desviaci N Est Ndar PDFDocument22 pages06 Desviaci N Media Varianza Desviaci N Est Ndar PDFDennis Cristhian Cuno TiconaNo ratings yet

- Ejercicios de Modelos Continuos PDFDocument3 pagesEjercicios de Modelos Continuos PDFFelipe RetamalNo ratings yet

- Variable Aleatoria ContinuaDocument18 pagesVariable Aleatoria Continuajuan perca100% (1)

- Parcial Final de EstadisticaDocument7 pagesParcial Final de Estadisticarubco1982No ratings yet

- Organización Del Bachillerato InternacionalDocument21 pagesOrganización Del Bachillerato InternacionalEmily ManchenoNo ratings yet

- Dis 2daDocument24 pagesDis 2daDaniel QuinterosNo ratings yet

- Practica Labotarorio 1 - Geoquimica - Sección B - Grupo2 - 14Document10 pagesPractica Labotarorio 1 - Geoquimica - Sección B - Grupo2 - 14Brayan Loayza PozúNo ratings yet

- Funciones ExcelDocument49 pagesFunciones ExcelBeto 4No ratings yet

- Repaso Prueba Dist. BinomialDocument4 pagesRepaso Prueba Dist. BinomialCINTYA FERNANDA CAAMAÑO FUENTESNo ratings yet

- Prob Micro 100Document40 pagesProb Micro 100Jimmy SanchezNo ratings yet

- TEORIADocument3 pagesTEORIAneider chaves contrerasNo ratings yet

- Medidas de Tc-Posicion y VariabilidadDocument13 pagesMedidas de Tc-Posicion y VariabilidadCARMEN DEL ROSARIONo ratings yet

- Control 2 Salcedo 202112663Document2 pagesControl 2 Salcedo 202112663Wuendy RocíoNo ratings yet

- Tarea #9 Variable Aleatoria Función de Probabilidad y Función de Distribución. Medidas Estadísticas en Una Variable Aleatoria.Document2 pagesTarea #9 Variable Aleatoria Función de Probabilidad y Función de Distribución. Medidas Estadísticas en Una Variable Aleatoria.Carla Solorzano cruzNo ratings yet

- Universidad Nacional de Jaén: Vicepresidencia AcadémicaDocument19 pagesUniversidad Nacional de Jaén: Vicepresidencia AcadémicaJHUNIOR YOMAR BARDALES SUAREZNo ratings yet

- Taller Probabilidad #1Document34 pagesTaller Probabilidad #1JAJA JAJANo ratings yet

- Pract 3 2011 PDFDocument4 pagesPract 3 2011 PDFJose Perez RevertetNo ratings yet

- U5 Ac1 EstadisticaDocument11 pagesU5 Ac1 EstadisticaSCNo ratings yet

- Tomamos decisiones objetivas con medidas estadísticasDocument24 pagesTomamos decisiones objetivas con medidas estadísticasLuis fabiano Rivera canalesNo ratings yet

- Fase 2Document7 pagesFase 2Fernando VasquezNo ratings yet