Professional Documents

Culture Documents

Teoria Algoritmica de La Informacion Wiki

Uploaded by

Gianella Cloud DoloresOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Teoria Algoritmica de La Informacion Wiki

Uploaded by

Gianella Cloud DoloresCopyright:

Available Formats

Teor�a algor�tmica de la informaci�n

Ir a la navegaci�nIr a la b�squeda

La teor�a algor�tmica de la informaci�n, es una teor�a cient�fica de las ciencias

de la computaci�n, que en contraste con la cl�sica teor�a de la informaci�n, se

basa en la complejidad de Kolmogorov para la determinaci�n del contenido de la

informaci�n. Fue desarrollada principalmente por Gregory Chaitin, Andrey Kolmogorov

y Ray Solomonoff.

�ndice

1 Introducci�n

2 Ejemplo

3 Antecedentes Matem�ticos

4 Enlaces externos

Introducci�n

La teor�a algor�tmica de la informaci�n, principalmente estudios de las medidas de

complejidad en las cadenas (o estructuras de datos). Como la mayor�a de los objetos

matem�ticos pueden ser descritos en t�rminos de cadenas, o como el l�mite de una

secuencia de cadenas, puede ser usado para estudiar una amplia variedad de objetos

matem�ticos, incluyendo n�meros enteros y n�meros reales.

Algunos de los resultados de la teor�a algor�tmica de la informaci�n, como el

teorema de incompletitud de Chaitin, parecen desafiar intuiciones matem�ticas y

filos�ficas. El m�s notable de ellos es la construcci�n de la constante de Chaitin

O, un n�mero real que expresa la probabilidad de que una de m�quina universal de

Turing de auto-delimitaci�n puede detenerse con datos de entrada generadas por

lanzamientos de moneda.

Ejemplo

Seg�n la definici�n cl�sica, de acuerdo con Claude Shannon, el contenido de la

informaci�n de las siguientes secuencias binarias es la misma (s�lo aplica la

entrop�a de primer orden):

1100100001100001110111101110110011111010010000100101011110010110

1111111111111111111111111111111100000000000000000000000000000000

La primera secuencia ha sido producida por un muestreo aleatorio, en la segunda

secuencia, sin embargo, se utiliza la instrucci�n "32x1 a continuaci�n, y entonces

32X0". A los efectos de la teor�a algor�tmica de la informaci�n, la primera

secuencia por tanto, tiene m�s informaci�n algor�tmica , ya que es mucho m�s

compleja o no se puede comprimir. Es decir, la informaci�n algor�tmica es tanto

mayor, cuanto menos puede ser comprimida una cadena de caracteres (entre otros, por

compresi�n de datos). Las secuencias aleatorias y ruido blanco en general no

contienen ning�n patr�n predecible y por tanto no son compresibles - el contenido

de la informaci�n algor�tmica es por tanto mayor.

Antecedentes Matem�ticos

El enfoque de Andrei Kolmogorov se puede aplicar tambi�n a los algoritmos de

programas arbitrarios de una m�quina de Turing. Gregory Chaitin aplicando la

complejidad de Kolmogorov en la teor�a de las funciones recursivas (ver tambi�n �-

recursion c�lculo lambda y el trabajo relacionado de Kurt G�del), limita las

aplicaciones posibles a las que se pueden ejecutar en una variante especial de la

m�quina universal de Turing (UTM), llamada m�quina universal de Turing con

autodelimitaci�n.

Tras la demostraci�n de Chaitin, en principio, no se puede determinar si una cadena

se puede reducir a�n m�s algoritmicamente. Por ejemplo, se han encontrado nuevos y

m�s eficientes algoritmos de compresi�n, pero una secuencia aparentemente aleatoria

de n�meros puede venir de un generador pseudo-aleatorio. Debido al problema de

parada (Halting Problem) no todas las m�quinas de Turing pueden ser utilizadas un

tiempo finito.

Enlaces externos

C�mo ejecutar algor�tmica Teor�a de la Informaci�n en un equipo por Gregory

Chaitin(en ingl�s)

Los l�mites de las matem�ticas por Gregory Chaitin, incluyendo un int�rprete para

un extendido LISP para simular autolimitada UTM(en ingl�s)

Mensajes de comprimido de los extranjeros id�ntico al ruido

You might also like

- Teoría Algorítmica de La Información - Wikipedia, La Enciclopedia LibreDocument2 pagesTeoría Algorítmica de La Información - Wikipedia, La Enciclopedia Librejoseamh69062247No ratings yet

- Constante de ChaitinDocument5 pagesConstante de ChaitinAle KuNo ratings yet

- La matemática discreta: Estudio de estructuras discretasDocument3 pagesLa matemática discreta: Estudio de estructuras discretasPii UouNo ratings yet

- Teoría de La ComputaciónDocument4 pagesTeoría de La Computaciónyorlady muñoz arcilaNo ratings yet

- Fase 1 - Pre SaberesDocument6 pagesFase 1 - Pre SaberesdavidNo ratings yet

- Discret at XTDocument7 pagesDiscret at XTEduardo SincheNo ratings yet

- Lógica ComputacionalDocument2 pagesLógica ComputacionalHenri LeoNo ratings yet

- Teorias TdsDocument9 pagesTeorias TdsRafa SánchezNo ratings yet

- Martinez Joseph AplicacionesdelalógicamatemáticaconotrascienciasDocument7 pagesMartinez Joseph AplicacionesdelalógicamatemáticaconotrascienciasJoseph MartínezNo ratings yet

- IA vs Fisica y FilosofiaDocument4 pagesIA vs Fisica y FilosofiaYury Luther Smith TellezNo ratings yet

- TeoríasDocument2 pagesTeoríasMARIAFERNANDA ZAMUDIO ALVAREZNo ratings yet

- HipercomputaciónDocument20 pagesHipercomputaciónfer bautistaNo ratings yet

- Utilidad de La Aritmetica Modular en Los Sistemas CriptograficosDocument64 pagesUtilidad de La Aritmetica Modular en Los Sistemas CriptograficosKarangano Kamaraju Castro ChavezNo ratings yet

- Complejidad Algoritmica PDFDocument11 pagesComplejidad Algoritmica PDFAndres Mauricio Guevara RiverosNo ratings yet

- Reporte 4 Algoritmo de Ordenamiento y BusquedaDocument10 pagesReporte 4 Algoritmo de Ordenamiento y BusquedaFernando Marin CrabajalNo ratings yet

- Mii505 s3 Teoria ComplejidadDocument9 pagesMii505 s3 Teoria Complejidadpablo reyesNo ratings yet

- Matemáticas DiscretasDocument3 pagesMatemáticas Discretaskaren quintanillaNo ratings yet

- Matemática Discreta FundamentosDocument8 pagesMatemática Discreta FundamentosIrving AvilaNo ratings yet

- Presentación Teoria de La ComputacionDocument15 pagesPresentación Teoria de La Computaciondavid trochez moralesNo ratings yet

- Actividad Del Parcial 2Document11 pagesActividad Del Parcial 2shisuiNo ratings yet

- LógicaMatemática PDFDocument191 pagesLógicaMatemática PDFwalkiloNo ratings yet

- Matemáticas DiscretasDocument6 pagesMatemáticas DiscretasjosgauNo ratings yet

- Ensayo Sobre Lógica PlurivalenteDocument8 pagesEnsayo Sobre Lógica PlurivalenteAngelo Kstllanos100% (1)

- Complejidad AlgoritmicaDocument15 pagesComplejidad AlgoritmicaJhorlin Alvear roaNo ratings yet

- Teoría de La Complejidad ComputacionalDocument1 pageTeoría de La Complejidad ComputacionalRosmery BtNo ratings yet

- Métodos Ordenamiento AnálisisDocument30 pagesMétodos Ordenamiento AnálisisPablo Figueroa50% (2)

- Matematicas Discretas DefinicionDocument3 pagesMatematicas Discretas DefinicionJosecarlos GonzalezNo ratings yet

- Gramática Libre de ContextoDocument244 pagesGramática Libre de ContextoAra KaulitzNo ratings yet

- Paz Morillo BoschDocument11 pagesPaz Morillo BoschIsrael Chan CanNo ratings yet

- Grafos-Aplicaciones en La IngenieríaDocument16 pagesGrafos-Aplicaciones en La IngenieríaEdissonFranklinNo ratings yet

- Teoría de La Complejidad ComputacionalDocument11 pagesTeoría de La Complejidad ComputacionalmarcosNo ratings yet

- Teoría Computacional: Algoritmos y Problemas Resueltos EficientementeDocument4 pagesTeoría Computacional: Algoritmos y Problemas Resueltos EficientementeDiego OlmosNo ratings yet

- Complejidad Algoritmos - de La FUENTE ENZO MATÍASDocument7 pagesComplejidad Algoritmos - de La FUENTE ENZO MATÍASMatías de la FuenteNo ratings yet

- Introducción a la Criptografía de Curvas ElípticasDocument13 pagesIntroducción a la Criptografía de Curvas ElípticasHector Jose Ajnota CalderonNo ratings yet

- Aplicaciones en La Teoría de SistemasDocument4 pagesAplicaciones en La Teoría de SistemasKatherine PresillaNo ratings yet

- Teoría de Grafos para DumiesDocument4 pagesTeoría de Grafos para DumiesEdwin TorresNo ratings yet

- Algoritmos Como FuncionesDocument9 pagesAlgoritmos Como FuncionesJackrobin Vc JNo ratings yet

- AlgoritmoDocument6 pagesAlgoritmooriolNo ratings yet

- Investigacion Matematica DiscretaDocument8 pagesInvestigacion Matematica DiscretaRubenNo ratings yet

- Algoritmos y su representación en diagramas de flujoDocument2 pagesAlgoritmos y su representación en diagramas de flujoYarely H HernandezNo ratings yet

- Articulo - Complejidad EspacialDocument16 pagesArticulo - Complejidad EspacialLuis Martinez100% (2)

- Sintesis Unid IDocument5 pagesSintesis Unid IAnyelo SanchezNo ratings yet

- Medicion de AlgoritmosDocument12 pagesMedicion de AlgoritmosLuis Legu GuzmanNo ratings yet

- 1.introducción Lenguajes y AutómatasDocument7 pages1.introducción Lenguajes y AutómatasCarlos MerinoNo ratings yet

- Búsqueda de funciones booleanas criptográficasDocument24 pagesBúsqueda de funciones booleanas criptográficasOmar TurcoNo ratings yet

- Algoritmos más eficientes para calcular exponenciaciones en grupos multiplicativosDocument4 pagesAlgoritmos más eficientes para calcular exponenciaciones en grupos multiplicativosEmmanuel ZamoraNo ratings yet

- Matemáticas DiscretasDocument7 pagesMatemáticas Discretasjuanjo999No ratings yet

- Exposición InglésDocument9 pagesExposición Inglésaxeltapuy2006No ratings yet

- TP02 Trabajo de Investigación CriptografíaDocument2 pagesTP02 Trabajo de Investigación CriptografíaMarcos SocratesNo ratings yet

- Algoritmo Dijkstra grafos mínimosDocument3 pagesAlgoritmo Dijkstra grafos mínimoselthon avaroaNo ratings yet

- Trabajo Final Matematicas Discretas 2020 - 1Document25 pagesTrabajo Final Matematicas Discretas 2020 - 1Johnny G RamírezNo ratings yet

- Matemática DiscretaDocument10 pagesMatemática DiscretaEsteban Alexander Montero JavierNo ratings yet

- Analita Inteligencia ArtificialDocument8 pagesAnalita Inteligencia ArtificialSARA YOLANDA CANO QUINTERONo ratings yet

- Algoritmos Automatas Tiempo RealDocument106 pagesAlgoritmos Automatas Tiempo RealAdrian CarrionNo ratings yet

- AlgoritmoDocument11 pagesAlgoritmoLoNo ratings yet

- Cuales Son Las Aplicaciones de La Matemática DiscretaDocument1 pageCuales Son Las Aplicaciones de La Matemática DiscretaRAMIREZ07193No ratings yet

- Leonel Rondon 4to AñoDocument7 pagesLeonel Rondon 4to AñoOscar ZelayaNo ratings yet

- Complejidad 1x1Document99 pagesComplejidad 1x1José RojoNo ratings yet

- Tema 2 - Procesos Logicos - Parte 1Document5 pagesTema 2 - Procesos Logicos - Parte 1Jackie Vargas UribeNo ratings yet

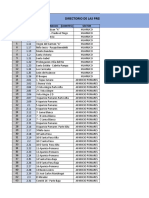

- Presidentas Del Comite Vaso de LecheDocument6 pagesPresidentas Del Comite Vaso de LecheGianella Cloud DoloresNo ratings yet

- Plan Ampliacion BosqueDocument2 pagesPlan Ampliacion BosqueGianella Cloud DoloresNo ratings yet

- Matriz de ConsistenciaDocument2 pagesMatriz de ConsistenciaGianella Cloud DoloresNo ratings yet

- Curriculum VitaeDocument3 pagesCurriculum VitaeGianella Cloud DoloresNo ratings yet

- Tema 5Document11 pagesTema 5Katherine ChavezNo ratings yet

- Objetiv OsDocument1 pageObjetiv OsGianella Cloud DoloresNo ratings yet

- METODOLOGÍADocument1 pageMETODOLOGÍAGianella Cloud DoloresNo ratings yet

- Proyectos de flujo de cajaDocument8 pagesProyectos de flujo de cajaGianella Cloud DoloresNo ratings yet

- Padron de Socios de La Asociacion de Comerciantes AmarilisDocument2 pagesPadron de Socios de La Asociacion de Comerciantes AmarilisGianella Cloud DoloresNo ratings yet

- Análisis de flujos de caja proyectados para tres empresas constructorasDocument9 pagesAnálisis de flujos de caja proyectados para tres empresas constructorasGianella Cloud DoloresNo ratings yet

- Dialnet PLANFENIX 4829082 PDFDocument41 pagesDialnet PLANFENIX 4829082 PDFAngela Gomez PumaNo ratings yet

- Informe #216 - 2021-Mda-Solicito Certificacion PresupuestalDocument1 pageInforme #216 - 2021-Mda-Solicito Certificacion PresupuestalGianella Cloud DoloresNo ratings yet

- Material FC-11Document14 pagesMaterial FC-11Gianella Cloud DoloresNo ratings yet

- Análisis PESTEL Danielito BusDocument3 pagesAnálisis PESTEL Danielito BusGianella Cloud DoloresNo ratings yet

- Tesis Reategui R FinalDocument156 pagesTesis Reategui R FinalGianella Cloud DoloresNo ratings yet

- METODOLOGÍADocument1 pageMETODOLOGÍAGianella Cloud DoloresNo ratings yet

- CATÁLOGODocument36 pagesCATÁLOGOGianella Cloud DoloresNo ratings yet

- Análisis PESTEL Danielito BusDocument3 pagesAnálisis PESTEL Danielito BusGianella Cloud DoloresNo ratings yet

- N° 169 La Teoría Del Pecking Order PDFDocument3 pagesN° 169 La Teoría Del Pecking Order PDFBlas SantiagoNo ratings yet

- Material FC-12Document25 pagesMaterial FC-12Gianella Cloud DoloresNo ratings yet

- N° 169 La Teoría Del Pecking Order PDFDocument3 pagesN° 169 La Teoría Del Pecking Order PDFBlas SantiagoNo ratings yet

- Marketing: identificar necesidades consumidoresDocument2 pagesMarketing: identificar necesidades consumidoresGianella Cloud DoloresNo ratings yet

- Contenido: Área FinanzasDocument2 pagesContenido: Área FinanzasGerman Sosa PaucarNo ratings yet

- Plan Record GuinnessDocument7 pagesPlan Record GuinnessGianella Cloud DoloresNo ratings yet

- Teoria Sobre La Estructura de Capital - Universidad Del Valle - ColombiaDocument29 pagesTeoria Sobre La Estructura de Capital - Universidad Del Valle - ColombiaMaster119No ratings yet

- Merope RiddleDocument2 pagesMerope RiddleGianella Cloud DoloresNo ratings yet

- Teoria Sobre La Estructura de Capital - Universidad Del Valle - ColombiaDocument29 pagesTeoria Sobre La Estructura de Capital - Universidad Del Valle - ColombiaMaster119No ratings yet

- NeonatoDocument10 pagesNeonatoGianella Cloud DoloresNo ratings yet

- HogsmeadeDocument3 pagesHogsmeadeGianella Cloud DoloresNo ratings yet

- InferiousDocument1 pageInferiousGianella Cloud DoloresNo ratings yet

- Guia de TamizadoDocument11 pagesGuia de TamizadoMauro José FuentesNo ratings yet

- Geometria Analitica Hugo Iniguez Pdf1818302753Document313 pagesGeometria Analitica Hugo Iniguez Pdf1818302753Mario89% (28)

- Instrucciones de Uso Del Menu EngineeringDocument3 pagesInstrucciones de Uso Del Menu EngineeringAntonio Jimenez RamirezNo ratings yet

- Influencia Del Material Didáctico en El Aprendizaje de Los Alumnos Del Segundo Año DDocument4 pagesInfluencia Del Material Didáctico en El Aprendizaje de Los Alumnos Del Segundo Año DManuel Pedro Vasquez Galan0% (1)

- Solucionario - Semana Nâ°18 - Ciclo 2023-I Por Alberto CruzDocument120 pagesSolucionario - Semana Nâ°18 - Ciclo 2023-I Por Alberto CruzjairsobrinopiscoNo ratings yet

- CUESTIONARIO Segundo Parcial PDFDocument3 pagesCUESTIONARIO Segundo Parcial PDFJuan Carlos Olmedo QuiñonezNo ratings yet

- Actividad 21 (Exponencial y Logarítmica) FMMP 012Document2 pagesActividad 21 (Exponencial y Logarítmica) FMMP 012josepha acuñaNo ratings yet

- Procedimiento de Instalacion de TanquesDocument4 pagesProcedimiento de Instalacion de TanquesJose PerezNo ratings yet

- Rúbrica 2.1 Currículum VitaeDocument1 pageRúbrica 2.1 Currículum VitaeGraciela Hernandez MartinezNo ratings yet

- Resonancia en Puentes Colgantes IIDocument16 pagesResonancia en Puentes Colgantes IIJHON RONY HUILLCAS JUÑO100% (1)

- Temario Diplomado en Psicologia ForenseDocument4 pagesTemario Diplomado en Psicologia ForenseCIPASNo ratings yet

- Triptico Pasos 'Para Mantenimiento Prevetivo de PCDocument2 pagesTriptico Pasos 'Para Mantenimiento Prevetivo de PCReyna Lopez Hernandez25% (4)

- Dictamen DactiloscopicoDocument5 pagesDictamen DactiloscopicoAlejandra FallaNo ratings yet

- Cgeu - Cgeu-247 - Formatoalumnotrabajofinal (1) Jeffry Anderson Pancca QuilluyaDocument14 pagesCgeu - Cgeu-247 - Formatoalumnotrabajofinal (1) Jeffry Anderson Pancca Quilluyareesro891No ratings yet

- Guia 1. Estat Descriptiva 1 VarDocument48 pagesGuia 1. Estat Descriptiva 1 VarGUSTAVO VALLEJOS SANCHEZNo ratings yet

- Informe Rsu Nacional DiagnósticoDocument29 pagesInforme Rsu Nacional DiagnósticoAndres TorresNo ratings yet

- El Diseño de Banquetas en La CDMX - Lineamientos para El Diseño y ConstrucciónDocument97 pagesEl Diseño de Banquetas en La CDMX - Lineamientos para El Diseño y Construcciónowlie mccloud100% (2)

- Movimiento de TierrasDocument144 pagesMovimiento de TierrasJimPjl89% (19)

- Quisqueya Verde Desarrolla Economía de MontañasDocument4 pagesQuisqueya Verde Desarrolla Economía de MontañasAlexandra MaldonadoNo ratings yet

- Historia Desconocida de Los Hombres-Robert Charroux PDFDocument346 pagesHistoria Desconocida de Los Hombres-Robert Charroux PDFjhony9664% (11)

- Actividad 5.3.2 Activo o Sedentario. Como Soy YoDocument6 pagesActividad 5.3.2 Activo o Sedentario. Como Soy Yoagosto14No ratings yet

- Identificación de no conformidades en procesos de calidadDocument10 pagesIdentificación de no conformidades en procesos de calidadMABEL YULISSA YUNDA LOPEZNo ratings yet

- Informe Elementos de MaquinasDocument34 pagesInforme Elementos de MaquinasGabi Soto FaúndezNo ratings yet

- Foro de DiscusionDocument6 pagesForo de DiscusionAnyie CoboNo ratings yet

- Programa de Intervencion de AutoestimaDocument37 pagesPrograma de Intervencion de Autoestimawhite_night100% (2)

- Plan de Seguimiento para EgresadosDocument8 pagesPlan de Seguimiento para EgresadosMarcos García RodríguezNo ratings yet

- Rubrica de La Primera UnidadDocument10 pagesRubrica de La Primera UnidadZoniaLòpezRegaladoNo ratings yet

- Tantra El Camino Del AmorDocument1 pageTantra El Camino Del AmorVerstat BohintukNo ratings yet

- Documentos Primaria Sesiones Unidad06 PrimerGrado Integrados 1G-U6-Sesion20Document6 pagesDocumentos Primaria Sesiones Unidad06 PrimerGrado Integrados 1G-U6-Sesion20A̶n̶d̶r̶e̶ ̶D̶'̶K̶x̶a̶y̶No ratings yet

- Trabajo Final Numero 2 EstadisticaDocument17 pagesTrabajo Final Numero 2 EstadisticaAna Belen SomocurcioNo ratings yet